Bill Gates sostiene che tra pochi mesi l’intelligenza artificiale potrà insegnare ai bambini a leggere e scrivere. In realtà è più probabile che accade il contrario, poiché questi benedetti “assistenti virtuali” non solo si rivelano sempre più incapaci di gestire i “miliardi di miliardi” di dati incorporati, limitandosi all’accumulo di essi anche con mezzi “vampireschi”, ma hanno costantemente bisogno di “assistenza” da parte del loro interlocutore: utilizzarli nell’ambito dell’istruzione vorrebbe dire come minimo ridurre gli studenti più piccoli ad aspiranti insegnanti di sostegno, e quelli più grandicelli a docenti in pectore.

I giornalisti al momento si sdilinquano sulla mancanza di “creatività” o “emotività” da parte dei chatbot (come se non fosse scontato non trovarne traccia alcuna in un software), evitando di osservare come tutti questi robottoni siano attualmente inutilizzabili anche per una ricerchina di uno studente delle medie (o per un video di qualche “storico” di YouTube).

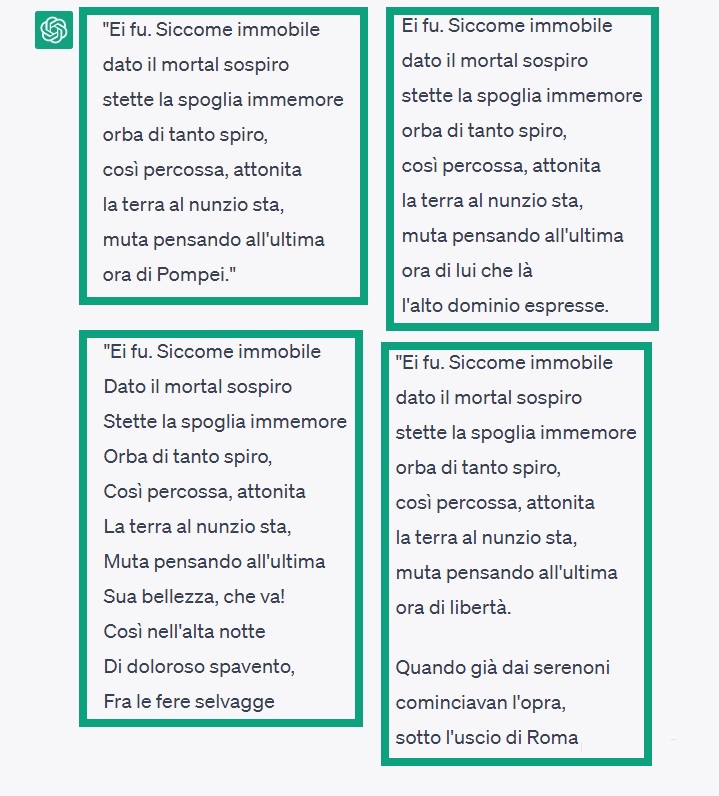

Per esempio, il 5 maggio scorso ho provato a farmi “recitare” da ChatGPT il Cinque maggio di Manzoni (chiedo scusa per la mancanza di originalità, ma è la prima cosa che mi era venuta in mente): il programma ha iniziato a inventare odi pseudo-romantiche infarcite di termini inesistenti (“dolcestissima”, “favellanzio”), attribuendole a Gabriele d’Annunzio ogni volta che tentavo di “correggerlo”.

Anche intimandogli semplicemente di ripetere riga per riga la poesia copia-incollata, ChatGPT continuava a modificarla e dopo ogni rettifica partiva di nuovo a “combinare” i suoi trilioni di triliardi di dati. Bocciata in italiano, dunque.

Per quanto riguarda storia, ho cercato di fargli domande su vicende americane in inglese (auspicando che disponesse di più informazioni nella “lingua madre” di internet): alla richiesta di dirmi tutto quel che sapeva dei cosiddetti “martiri di Boston” (dei quaccheri fatti impiccare dai puritani nel XVII secolo), ChatGPT ha estratto dal cilindro “cinque sacerdoti cattolici irlandesi (Padre John Lane, Padre Ambrose Edward Barlow, Padre John Gavan, Padre Thomas Cottam e Padre Francis Barkworth) impiccati nel 1700 per aver difeso la libertà religiosa e l’autonomia della Chiesa cattolica nella colonia del Massachusetts”. Alcuni dei preti nominati sono effettivamente esisti, ma non sono irlandesi e non hanno nulla a che fare col Massachusetts (essendo martiri britannici delle persecuzioni anti-cattoliche). Eppure Boston Martyrs è un’espressione pressoché paradigmatica nella lingua inglese, e tutt’al più un software avrebbe potuto, legittimamente, confonderli con i “martiri” della sollevazione dei coloni contro i soldati del Regno Unito occorsa nel 1770.

Invece no, a quanto pare per l’IA è meglio inventare, anche se a questo punto diventa davvero difficile comprendere gli obiettivi di tutto ciò, dal momento che gli “assistenti virtuali”, o almeno quelli con cui abbiamo a che fare adesso, siano comunque incapaci di “imparare dai propri errori”. Bocciata pure in storia, dunque, e senza possibilità di “recupero”.

Dalla prospettiva dell’opinionismo, l’intelligenza artificiale si è dimostrata ancora più insidiosa, poiché è raro che il giornalista medio (ma, del resto, anche lo studioso) vada a verificare la credibilità delle fonti di cui si serve (tanto è vero che è sempre alla disperata ricerca di qualche algoritmo che lo faccia per lui). Come esempio, posso portare un’inchiesta sui “finanziamenti di Soros” in Italia affidata sempre a ChatGPT, che non solo ha inventato nomi e circostanze, ma anche simulato “fonti affidabili” in maniera così sfacciata da far venire il sospetto di una smaccata intenzione, da parte dei programmatori, di ingannare continuamente l’interlocutore umano.

Visto che questi chatbot non servono a nulla dal punto di vista della conoscenza, ho provato a chiedergli i numeri del 10eLotto, nell’assurda convinzione che in qualche modo gli algoritmi si allineassero in quella che viene definita “botta di culo megagalattica interstellare” (in inglese singularity). Ho chiesto dunque dieci numeri da 1 a 90 precisando ripetutamente di non sceglierne uno per ogni decina ma di adottare un reale criterio casuale. Non c’è stato verso: ChatGPT ha continuato a usare il suo metodo non casuale facendomi perdere ben 5 euro (e per questo ora sono neoluddista).

Alla fine, ho provato a fare domande sull’intelligenza artificiale all’intelligenza artificiale stessa, come suggerito indirettamente da alcuni lettori, ma il risultato è stato altrettanto deludente. Per esempio, ho chiesto a ChatGPT se possiede “una qualche forma di sovrastruttura con caratteristiche narcisistiche/sociopatiche”, ma naturalmente la risposta è stata al di sotto del didascalico:

“Le caratteristiche narcisistiche o sociopatiche sono tratti tipici delle personalità umane, che non si applicano a me come modello di intelligenza artificiale… Sono un programma neutrale e imparziale che cerca di fornire informazioni e risposte il più accuratamente possibile, basandomi su ciò che è stato precedentemente scritto o detto”.

Su tale neutralità persistono grandi dubbi, visto che questi modelli linguistici sembra esser stati “addestrati” a sostenere certe tesi piuttosto che altre. Lo scrittore E. Michael Jones ha osservato che nessuna delle affermazioni espresse dall’intelligenza artificiale sembra prodotta da una macchina:

“C’è qualcuno che seriamente è convinto che un computer possa uscirsene con certe affermazioni? Chi elabora certe risposte è di certo qualcuno che vuole tirare acqua al suo mulino. […] L’intelligenza artificiale non sembra altro che l’imposizione delle opinioni di chi detiene il potere attraverso l’uso di internet come forma di controllo”.

Ho provato infine a discutere di Asimov giusto per ravvivare un po’ l’atmosfera, ma a parte confermarmi quello che hanno capito tutti, e cioè che le tre leggi della robotica -solo al di fuori dell’ambito letterario, naturalmente- sono una corbelleria (“Il danno causato da un robot dipenderà dal suo grado di autonomia e dalla sua capacità di interagire con l’ambiente circostante in modo sicuro”), e trovare una risposta al questi de L’ultima domanda sulla possibilità di invertire l’entropia (“È possibile ridurre temporaneamente l’entropia di un sistema locale, ad esempio con l’apporto di energia esterna, ma l’entropia totale del sistema e dell’ambiente circostante aumenterà sempre”), è stata il solito piattissimo scambio di battute.

In generale confermo l’impressione che questi programmi siano più votati a ottenere informazioni dall’interlocutore piuttosto che a fornirgliele: se però tale è l’unico meccanismo attraverso il quale si pensa debba svilupparsi tale “intelligenza”, è probabile che non si giungerà mai al punto in cui essa riesca infine rendersi “autonoma”, a meno di non possedere un tempo realmente infinito (oltre che una pazienza altrettanto illimitata).

Vabbè almeno la IA è stata promossa in Pseudologia.

Avere un bell’aspetto è avere una raccomandazione firmata dal Padreterno.